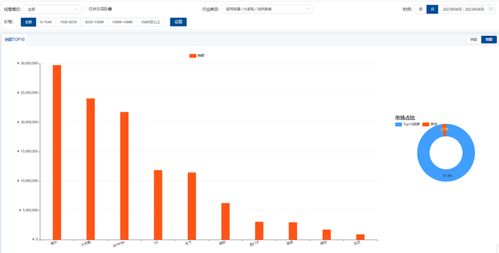

實時BI(三) 離線數據與實時數據處理的技術實現

在實時商業智能(Real-time BI)的架構中,離線數據處理與實時數據處理是兩大核心支柱,它們共同支撐著從海量數據中快速提取洞察的能力。本文將深入探討這兩種數據處理模式的技術實現路徑,以及它們如何協同工作,為現代數據分析與處理提供強大動力。

1. 離線數據處理:批量計算的基石

離線數據處理,通常指對靜態、大規模數據集進行批量計算和分析。其核心特征是處理周期較長(如小時、天或周級別),但能夠執行復雜、深度的計算任務。

技術實現要點:

- 存儲層: 主要依賴于分布式文件系統(如HDFS)或對象存儲(如AWS S3),用于存放原始日志、事務記錄等歷史數據。

- 計算引擎: 以Apache Hadoop MapReduce、Apache Spark(批處理模式)為代表。Spark憑借其內存計算和DAG執行引擎,在迭代計算和復雜ETL任務上性能顯著。

- 調度與管理: 使用Apache Airflow、Oozie等工作流調度工具,實現依賴管理、定時觸發與監控。

- 數據倉庫: 經過清洗、轉換后的數據被加載到數據倉庫(如Hive、ClickHouse)或數據湖中,供后續的離線報表、即席查詢使用。

離線處理的優勢在于其強大的吞吐量和處理深度,適合構建企業級的“單一事實來源”,為戰略決策提供歷史趨勢分析和宏觀視角。

2. 實時數據處理:即時洞察的引擎

實時數據處理則關注對持續不斷產生的數據流進行即時處理,力求在毫秒到秒級內完成計算并輸出結果,以支持實時監控、預警和個性化推薦等場景。

技術實現要點:

- 數據采集與接入: 通過消息隊列(如Apache Kafka、Pulsar)作為數據流的“中樞神經系統”,以高吞吐、低延遲的方式接收來自應用日志、IoT設備等的實時事件。

- 流計算引擎: 這是實時處理的核心。Apache Flink因其真正的流式處理架構(低延遲、高容錯)、精確一次(exactly-once)語義和豐富的狀態管理而成為主流選擇。Apache Storm和Spark Streaming也各有其應用場景。

- 實時計算模式: 主要包括窗口計算(如滾動窗口、滑動窗口)、流式聚合、復雜事件處理(CEP)以及流批一體(如Flink Table API/SQL)等。

- 結果輸出: 處理后的實時指標或事件可實時寫入OLAP數據庫(如Druid、ClickHouse)、鍵值存儲(如Redis)或直接推送至前端儀表板,實現秒級可視化。

實時處理的價值在于其時效性,它讓企業能夠對正在發生的業務動態做出快速反應,優化運營效率與用戶體驗。

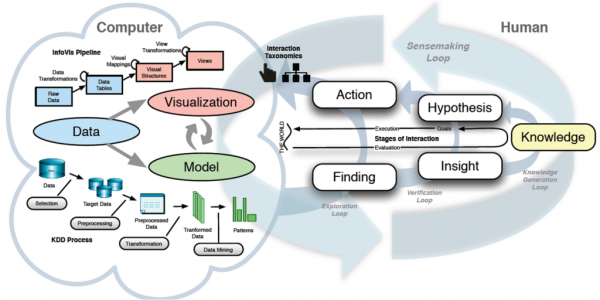

3. 離線與實時的協同:Lambda與Kappa架構

在實際系統中,離線與實時處理并非割裂,而是通過特定架構模式協同互補。

- Lambda架構: 這是經典的混合架構。數據流同時進入批處理層(離線)和速度層(實時)。批處理層提供準確、全面的歷史視圖;速度層提供近實時的最新視圖。服務層將兩者結果合并后提供給應用。其優點是兼顧準確性與時效性,但缺點是需要維護兩套邏輯不同的代碼庫,系統復雜性高。

- Kappa架構: 作為Lambda架構的簡化,它主張只保留流處理層。所有數據,無論歷史還是實時,都通過消息隊列接入,并由同一套流處理引擎(如Flink)處理。對于歷史數據的重新計算,通過從頭消費持久化的消息日志來實現。Kappa架構統一了技術棧,降低了運維復雜度,但對消息隊列的存儲能力和流處理引擎的回放計算能力要求更高。

隨著Flink等流批一體引擎的成熟,一種新的趨勢是流批融合。開發者可以用同一套API(如SQL)來描述處理邏輯,引擎根據數據源特性(有限數據集/無界數據流)自動選擇執行模式,從根本上簡化了架構。

4. 技術選型與未來展望

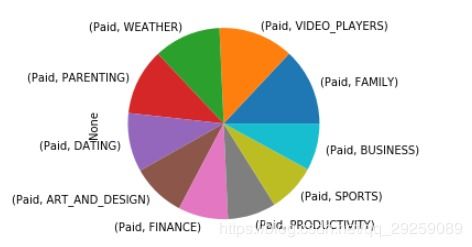

選擇離線、實時還是混合架構,取決于具體的業務需求、數據特性(速度、體量、多樣性)以及對數據一致性、延遲和準確性的要求。

- 離線處理仍是數據倉庫建設、訓練機器學習模型和生成深度分析報告的基礎。

- 實時處理則是數字化轉型中實現敏捷運營、實時風控和智能交互的關鍵。

數據處理技術的發展將繼續朝著統一化、實時化和智能化邁進。流批一體的計算引擎將逐漸成為標準,云原生與Serverless架構將進一步提升資源彈性與運維效率,而AI與數據處理的深度融合(如實時特征計算、流式模型推理)將催生出更加智能的實時BI應用,讓數據驅動的決策真正變得無處不在、無時不在。

如若轉載,請注明出處:http://www.xiuliu.com.cn/product/53.html

更新時間:2026-01-07 09:52:01